Combiner l'IA et les sciences du comportement de manière responsable

Si vous n'avez pas passé les cinq dernières années à vivre sous une roche, vous avez probablement entendu parler d'au moins une façon dont l'intelligence artificielle (IA) est appliquée à quelque chose d'important dans votre vie. Qu'il s'agisse de déterminer les caractéristiques musicales d'une chanson à succès pour des producteurs nommés aux Grammy1 ou d'entraîner le rover Curiosity de la NASA à mieux naviguer dans son environnement martien abstrait2, l'IA est aussi utile qu'omniprésente. Pourtant, malgré l'omniprésence de l'IA, peu de gens comprennent vraiment ce qui se passe sous le capot de ces algorithmes complexes - et, ce qui est inquiétant, peu de gens semblent s'en soucier, même lorsque cela a un impact direct sur la société. Prenons l'exemple du Royaume-Uni, où un conseil municipal sur trois utilise l'IA pour prendre des décisions en matière d'aide sociale, qu'il s'agisse de décider où les enfants iront à l'école ou d'enquêter sur les demandes d'allocations pour détecter les fraudes.3

Qu'est-ce que l'IA ?

En termes simples, l'IA décrit des machines qui sont conçues pour penser et agir comme des humains. Comme nous, les machines IA peuvent apprendre de leur environnement et prendre des mesures pour atteindre leurs objectifs sur la base de leurs expériences passées. L'intelligence artificielle a été inventée pour la première fois en 1956 par John McCarthy, professeur de mathématiques au Dartmouth College.4 McCarthy a affirmé que chaque aspect de l'apprentissage et d'autres caractéristiques de l'intelligence humaine peuvent, en théorie, être décrits avec une telle précision qu'une machine peut être fabriquée pour les simuler mathématiquement.

À l'époque de McCarthy, l'IA n'était qu'une simple conjecture dont la portée se limitait à une série de séances de remue-méninges par des mathématiciens idéalistes. Aujourd'hui, elle connaît une sorte de renaissance grâce aux progrès massifs de la puissance de calcul et à la quantité de données dont nous disposons.

Si les représentations dystopiques post-humaines de l'IA avancée peuvent sembler farfelues, il faut garder à l'esprit que l'IA, même sous sa forme actuelle et relativement rudimentaire, reste un outil puissant qui peut être utilisé pour créer des effets bénéfiques ou néfastes pour la société. Les enjeux sont encore plus importants lorsque les interventions en sciences du comportement font appel à l'IA. Des résultats problématiques peuvent survenir lorsque l'utilisation de ces outils est dissimulée au public sous un voile de technocratie - en particulier si les machines d'IA développent les mêmes préjugés que leurs créateurs humains. Il existe des preuves que cela peut se produire, puisque des chercheurs ont même réussi à mettre délibérément en œuvre des biais cognitifs dans des algorithmes d'apprentissage automatique, selon un article publié dans Nature en 2018.5

Des machines qui agissent comme nous

Il s'agit d'un sous-ensemble de l'IA qui décrit les systèmes ayant la capacité d'apprendre automatiquement à partir de l'expérience, à l'instar des humains. L'apprentissage automatique est largement utilisé par les plateformes de médias sociaux pour prédire les types de contenu que nous sommes le plus susceptibles de lire, qu'il s'agisse des articles d'actualité qui s'affichent sur nos fils d'actualité Facebook ou des vidéos que YouTube nous recommande. Selon Facebook6, la ML est utilisée pour "connecter les gens avec le contenu et les histoires qui les intéressent le plus".

Pourtant, nous n'avons peut-être tendance à nous intéresser qu'aux choses qui renforcent nos croyances. Selon une analyse de McKinsey & Company, les sites de médias sociaux utilisent des algorithmes de ML pour "[filtrer] les nouvelles en fonction des préférences des utilisateurs [et renforcer] le biais de confirmation naturel des lecteurs".7 Pour les géants des médias sociaux, le biais de confirmation est une caractéristique, et non un bogue.

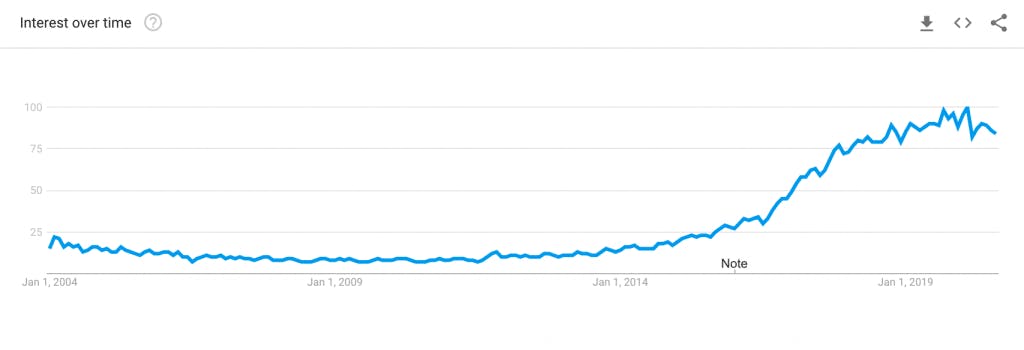

Recherches mondiales sur Google pour l'apprentissage automatique

Source : Google Trends

Source : Google Trends

Malgré les inquiétudes concernant les boucles de rétroaction générées par les ML qui créent des chambres d'écho idéologiques sur les sites de médias sociaux8 - ce qui pourrait en effet être un axiome fondé sur une vision incomplète de l'alimentation médiatique des individus, selon une étude de l'Oxford Internet Institute9 - ces applications des ML (et bien d'autres) ne sont pas intrinsèquement négatives. La plupart du temps, il peut être bénéfique pour nous d'être en contact avec les personnes et les contenus qui nous intéressent le plus. Toutefois, les utilisations problématiques de la ML peuvent entraîner de mauvais résultats : Si nous programmons les machines pour qu'elles optimisent les résultats en fonction de nos opinions et objectifs normatifs, c'est exactement ce qu'elles risquent de faire. Les machines d'IA ne sont aussi intelligentes, rationnelles, réfléchies et impartiales que leurs créateurs. Et, comme le montre le domaine de l'économie comportementale, la rationalité humaine a ses limites.

Quand l'IA est utilisée pour de mauvaises raisons

L'existence de biais ne signifie pas nécessairement que nous devrions ralentir ou arrêter notre utilisation de l'IA. Au contraire, nous devons être attentifs à ce qui se passe pour que l'IA ne devienne pas une sorte de boîte noire énigmatique sur laquelle nous avons ostensiblement peu de contrôle. L'intelligence artificielle et l'apprentissage automatique sont simplement des outils à notre disposition ; il nous appartient de décider comment les utiliser de manière responsable. Une attention particulière est requise lorsque nous utilisons un outil aussi puissant que l'intelligence artificielle - un outil qui, associé aux sciences du comportement, peut potentiellement exacerber les biais qui influencent notre prise de décision à une échelle sans précédent. Les mauvais résultats de ce partenariat pourraient inclure un renforcement des préjugés que nous avons à l'égard des personnes marginalisées, ou une myopie à l'égard du progrès équitable au nom d'une optimisation calculée. Les résultats médiocres pourraient inclure l'utilisation d'interventions en sciences comportementales infusées de ML pour nous vendre plus de choses dont nous n'avons pas besoin ou pour bureaucratiser nos environnements de choix dans une toile d'ennui. Ces outils pourraient également encourager la recherche pernicieuse de rentes par des entreprises peu inspirées, ce qui aurait pour effet d'étouffer l'innovation et d'affaiblir la concurrence.

Des coups de pouce ciblés

Y a-t-il quelque chose de bon à l'intersection de la ML et des sciences du comportement ? Avec un astérisque qui met fortement en garde contre les utilisations mauvaises ou médiocres - ou contre le fait d'étiqueter inconsidérément la ML comme une panacée sans faille - la réponse est oui. Les solutions de sciences comportementales qui sont complétées par la ML peuvent mieux prédire quelles interventions seront les plus efficaces et pour qui. La ML peut également nous permettre de créer des nudges personnalisés pour mieux s'adapter à des populations vastes et hétérogènes.10 Ces nudges personnalisés pourraient faire des merveilles pour répondre aux doutes concernant la validité externe des essais contrôlés randomisés, un type d'expérience couramment utilisé dans les sciences du comportement pour déterminer quelles interventions sont efficaces et dans quelle mesure elles le sont. Il n'est pas nécessaire d'être idéaliste pour penser aux nombreux problèmes politiques urgents qui pourraient bénéficier de "nudges" précis. Qu'il s'agisse de prédire quels messages seront les plus percutants pour des individus spécifiques ou de recommandations de santé personnalisées basées sur notre constitution génétique unique, de nombreux domaines politiques sont des candidats appropriés pour ce type d'interventions.

Aller de l'avant

Les avantages de l'utilisation de la ML pour améliorer les applications des sciences du comportement peuvent en effet l'emporter sur les risques de créer de mauvais résultats - et, peut-être de manière plus généralisée, des résultats médiocres. Pour que tout se passe bien, les sciences du comportement doivent jouer un rôle dans l'identification et la correction des préjugés néfastes qui influencent nos décisions et celles de nos machines intelligentes. Lorsque nous utilisons l'IA, nous devons rester fidèles à un principe clé des sciences du comportement : Les interventions doivent influencer notre comportement afin que nous puissions prendre de meilleures décisions pour nous-mêmes, sans interférer avec notre liberté de choix. Tout comme leurs créateurs, les machines intelligentes peuvent être partiales et imparfaites. Il est essentiel que nous en soyons conscients au fur et à mesure que le mariage entre les sciences du comportement et l'IA mûrit, afin que nous puissions utiliser ces outils à bon escient et de manière éthique.

References

1. Marr, B. (2017, 30 janvier). Alex Da kid, nominé aux Grammy Awards, crée un disque à succès grâce à l'apprentissage automatique. Forbes. https://www.forbes.com/sites/bernardmarr/2017/01/30/grammy-nominee-alex-da-kid-creates-hit-record-using-machine-learning/#79e589832cf9

2. NASA. (2020, 12 juin). Les pilotes du Mars Rover de la NASA ont besoin de votre aide - Programme d'exploration de Mars de la NASA. Programme d'exploration de Mars de la NASA. https://mars.nasa.gov/news/8689/nasas-mars-rover-drivers-need-your-help/

3. Marsh, S. (2019, 15 octobre). One in three councils using algorithms to make welfare decisions (Un conseil sur trois utilise des algorithmes pour prendre des décisions en matière d'aide sociale). the Guardian. https://www.theguardian.com/society/2019/oct/15/councils-using-algorithms-make-welfare-decisions-benefits

4. Nilsson, N. J. (2009). La quête de l'intelligence artificielle. Cambridge University Press.

5. Taniguchi, H., Sato, H. & Shirakawa, T. Un modèle d'apprentissage automatique avec des biais cognitifs humains capable d'apprendre à partir d'ensembles de données petits et biaisés. Sci Rep 8, 7397 (2018). https://doi.org/10.1038/s41598-018-25679-z

6. Facebook. (2017, 27 novembre). L'apprentissage automatique. Facebook Research. https://research.fb.com/category/machine-learning/

7. Baer, T. et Kamalnath, V. (2017, 10 novembre). Contrôler les algorithmes d'apprentissage automatique et leurs biais. McKinsey & Company. https://www.mckinsey.com/business-functions/risk/our-insights/controlling-machine-learning-algorithms-and-their-biases

8. Knight, M. (2018, 10 février). Voici pourquoi Facebook est une chambre d'écho si horrible. Business Insider. https://www.businessinsider.com/facebook-is-an-echo-chamber-2018-2

9. Blank, G. et Dubois, E. (2018, 9 mars). Le mythe de la chambre d'écho. OII | Oxford Internet Institute. https://www.oii.ox.ac.uk/blog/the-myth-of-the-echo-chamber/

10. Hrnjic, E. et Tomczak, N. (2019, 3 juillet). Machine learning and behavioral economics for personalized choice architecture. arXiv.org e-Print archive. https://arxiv.org/pdf/1907.02100.pdf

About the Author

Julian Hazell

Julian est passionné par la compréhension du comportement humain en analysant les données qui sous-tendent les décisions prises par les individus. Il s'intéresse également à la communication au public des connaissances en sciences sociales, en particulier à l'intersection des sciences du comportement, de la microéconomie et de la science des données. Avant de rejoindre le Decision Lab, il était rédacteur économique chez Graphite Publications, une publication montréalaise de pensée créative et analytique. Il a écrit sur divers sujets économiques allant de la tarification du carbone à l'impact des institutions politiques sur les performances économiques. Julian est titulaire d'une licence en économie et gestion de l'Université McGill.